GPT-4o(ジーピーティーフォーオー)とは、OpenAIによって開発されたマルチモーダルな最も先進的な大規模言語モデルです。GPT-4oでは、テキスト、音声、画像の組み合わせを入力することが可能であり、テキスト、音声、画像の組み合わせを生成します。

他のモデルと比較した際に、GPT-4oがとても優れている点は音声入力の速さです。音声入力には232ミリ秒で応答することができ、平均で320ミリ秒です。これは、人の応答速度と同等です。

今回は、GPT-4oに関する包括的な内容を解説します。

GPT-4oとは何ですか?

OpenAIのGPT-4oは、”o “はomni(「すべての」「普遍的な」という意味)を表し、2024年5月13日にライブストリーミングで発表とデモが行われました。GPT-4oは、OpenAIのGPT-4 with Visionの前モデルであるGPT-4 Turboをベースとした、テキスト、視覚、音声の入出力機能を備えたマルチモーダルモデルです。

GPT-4oが発表される前までは、ユーザーは音声モードを使ってChatGPTと対話することができ、3つの別々のモデルで動作していました。しかし、GPT-4oはこれらの機能を統合し、テキスト、視覚、音声にまたがって訓練された単一のモデルになりました。

この統一されたアプローチにより、テキスト、視覚、聴覚のすべての入力が、同じニューラルネットワークによって一貫して処理されることが保証されています。

下記は、OpenAIのYoutubeチャンネルで紹介されたGPT-4oのライブ配信の様子です。

5/14 にライブ配信

Youtube|OpenAI|Introducing GPT-4o

OpenAI Spring Update – streamed live on Monday, May 13, 2024.

Introducing GPT-4o, updates to ChatGPT, and more.

下記は、GPT-4oに関する概要を表形式でまとめたものです。

| GPT-4oに関する概要 | 詳細 |

|---|---|

| 多様なモード能力 | GPT-4oは、テキスト、オーディオ、画像、ビデオの入力と出力を処理し生成することができます。 |

| 応答時間 | オーディオ入力に対して最短232ミリ秒、平均で320ミリ秒で応答可能です。 |

| パフォーマンス | 英語とコーディングでGPT-4 Turboと同等の性能を持ち、非英語言語では大幅な改善があります。 |

| コストと速度 | GPT-4oは以前の最上位モデル(GPT-4 Turbo)と比べて50%安価で、API内での速度も向上しています。 |

| モデル統合 | テキスト、ビジョン、オーディオ処理を一つのニューラルネットワークで組み合わせています。 |

| 洗練された理解力 | 既存のモデルと比較して、ビジョンとオーディオの理解が向上しています。 |

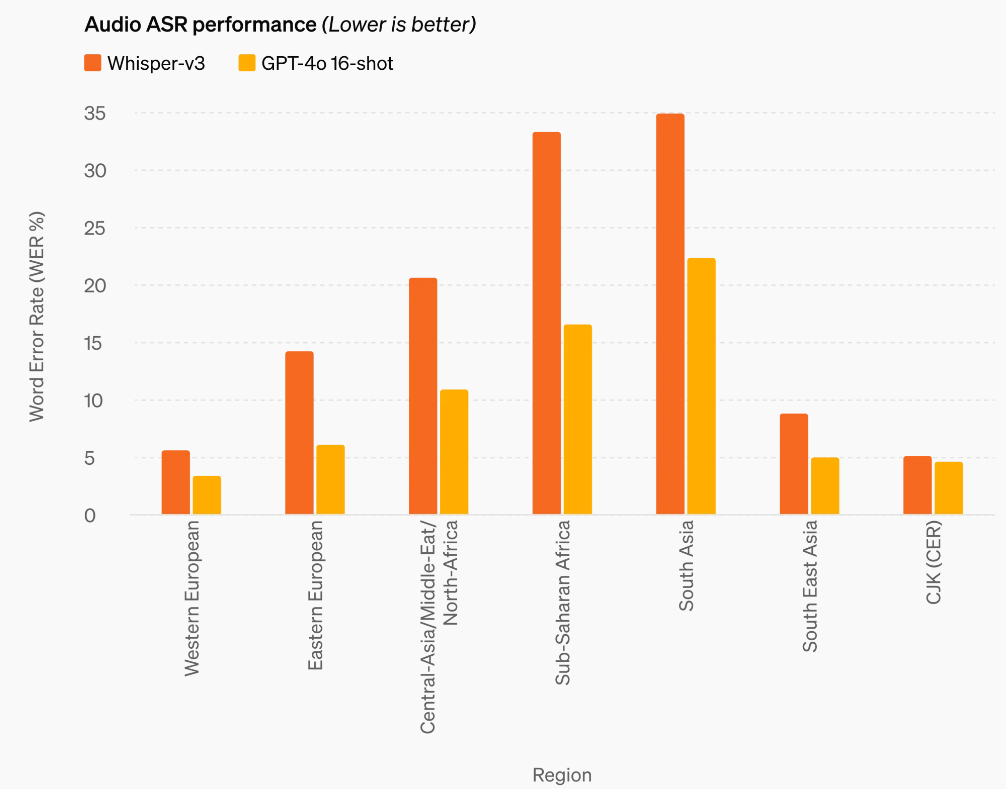

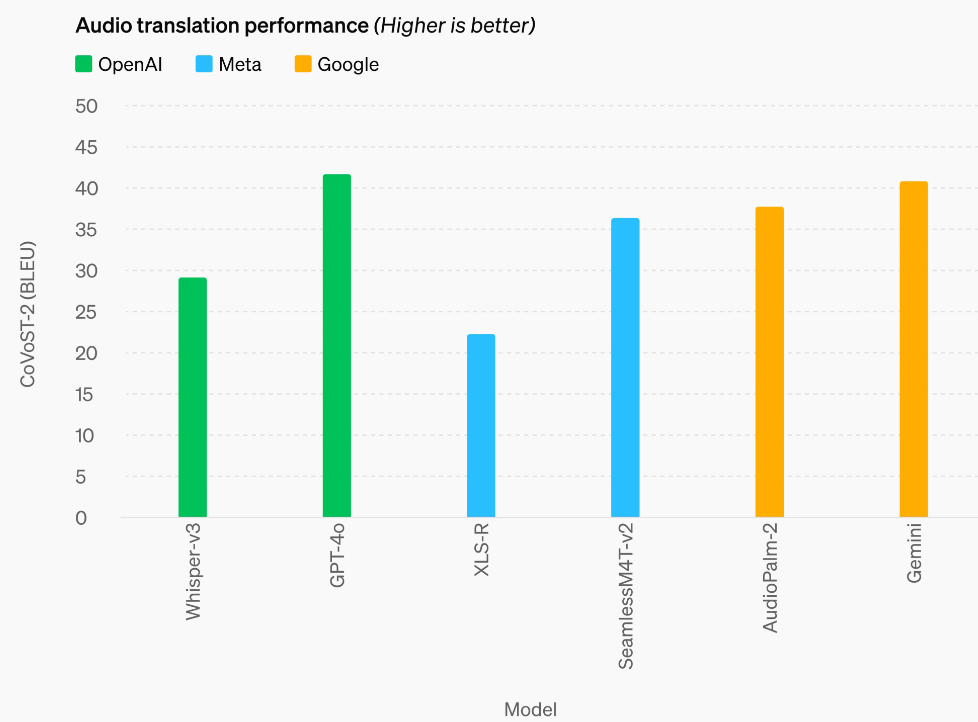

| 評価スコア | 一般知識問題に対する0-shot COT MMLUで88.7%を達成。多言語、オーディオ、ビジョン能力において新たな高得点を設定。Whisper-v3を音声認識と翻訳で上回る。 |

| 言語トークン化 | 20言語にわたるトークン圧縮を改善し、必要なトークン数を削減しました。 |

| 安全性 | トレーニングデータのフィルタリングやトレーニング後のモデル行動の洗練など、安全機能を内蔵しています。 |

| 外部テスト | 70名以上の各分野の外部専門家との広範囲にわたるテストを実施しました。 |

| 利用可能性 | ChatGPTでテキストと画像機能を段階的に展開中。無料プランとプラスユーザー向けに提供中で、メッセージ制限がより高く設定されています。開発者はAPIでGPT-4oにアクセスでき、オーディオとビデオ機能は信頼できるパートナーに近日中に公開されます。 |

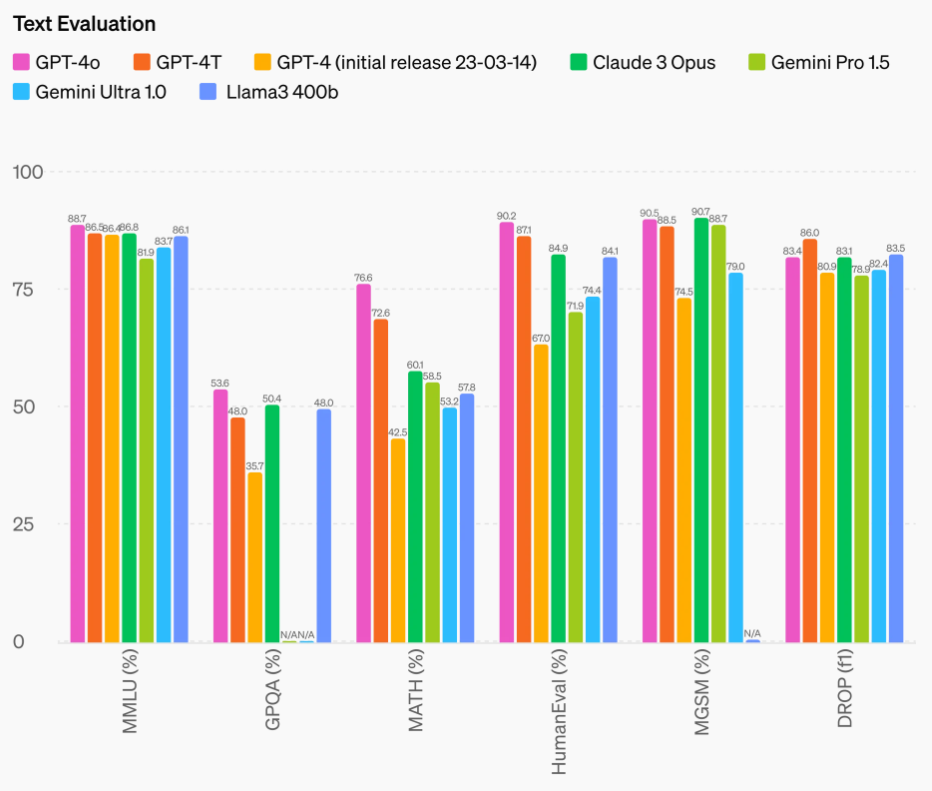

次に、OpenAIから公式発表されている資料をもとに、ベンチマークの結果について解説します。

GPT-4oの評価とベンチマーク結果

解説するGPT-4oの評価やベンチマーク結果は、以下の4つです。

- GPT-4oのテキスト生成

- GPT-4oの動画生成

- GPT-4oの音声生成

- GPT-4oの画像生成

それぞれ、順に解説します。

GPT-4oのテキスト生成の評価とベンチマーク結果

OpenAIが独自に発表したベンチマーク結果によると、テキストについては、GPT-4oは、従来までのモデルであるGPT-4やGPT-4 Turbo、AnthropicのClaude 3 Opus、GoogleのGemini、MetaのLlama3といった他のLMMと比較して、若干の改善、または同等のスコアを示しています。

なお、提供されたテキスト評価のベンチマーク結果では、OpenAIはMetaのLlama3の400bバリアントを比較していますが、公表時点では、Metaは400bバリアントモデルのトレーニングを終えていません。

GPT-4oの動画生成の評価とベンチマーク結果

GPT-4oの動画機能に関する説明として、GPT-4oのAPIは、視覚機能によるビデオ(音声なし)の理解をサポートしています。例えば、動画をAPIに直接送信することはできませんが、フレームをサンプリングすることで、GPT-4oは動画を処理することができます。OpenAI Cookbookによると、GPT-4oは、2024年5月時点では、まだ音声入力に対応できていないため、GPT-4とWhisperを組み合わせて、動画と音声を処理し、要約と質疑応答を行うことができます。

GPT-4oは、アップロードされた動画ファイルから動画と音声を表示し理解する能力と、短い動画を生成する能力の両方を持つことが実証されています。

GPT-4oの音声生成の評価とベンチマーク結果

GPT-4oでは、動画や画像と同様に、音声ファイルを取り込んで生成する能力を備えています。

GPT-4oは、生成される音声のきめ細かなコントロールが可能で、コミュニケーションの速度を変更したり、必要に応じて音色を変えたり、歌うことも可能になりました。

GPT-4oは、自身の出力を制御できるだけでなく、入力される音声を理解する能力も備えており、どのようなリクエストにも追加のコンテキストとして対応することができます。

OpenAI社が発表したベンチマーク結果によると、GPT-4oは、自動音声認識(ASR)におけるこれまでの最先端であったOpenAI独自のWhisper-v3を上回り、MetaやGoogleの他のモデルによる音声翻訳を上回っているとのことです。

GPT-4oの画像生成の評価とベンチマーク結果

GPT-4oは、素晴らしい画像生成の能力を持っており、一発参照ベースの画像生成や正確なテキスト描写のデモが行われています。

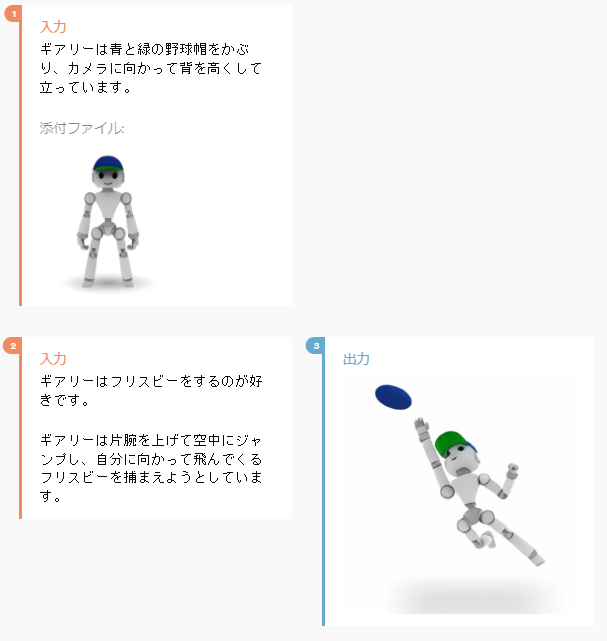

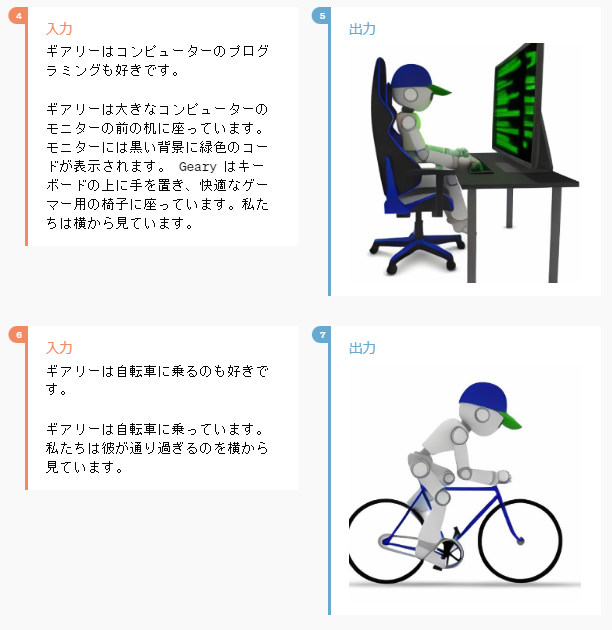

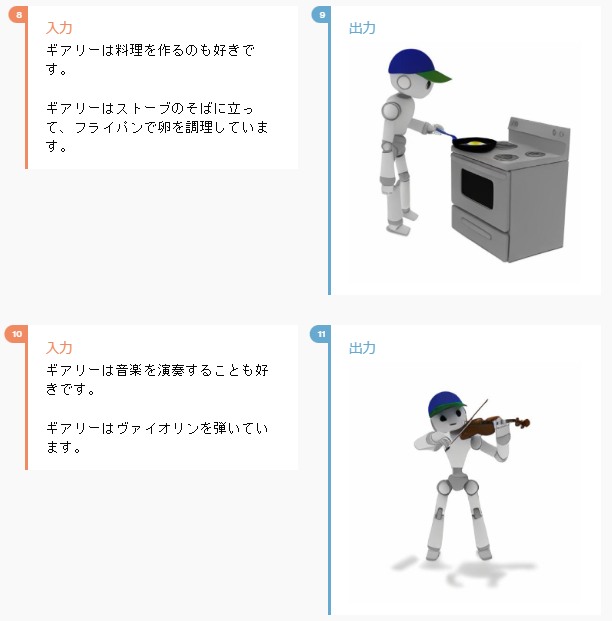

例えば、下記は、公式サイトで紹介されているGPT-4oの画像生成をテストするためのキャラクターデザインの例です。

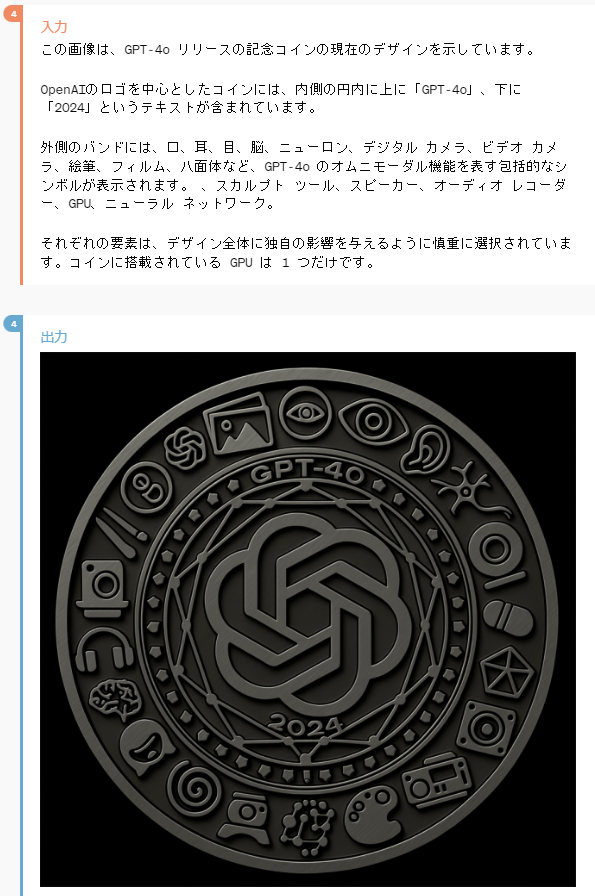

この他にも、GPT-4oの記念コインの画像生成の例が紹介されています。

GPT-4oに搭載されている画像生成技術ですが、他社に劣らない画像生成技術であると評価できます。画像生成系のAIは、単語のプロンプトを入力することが一般的でしたが、OpenAIのGPT-4oでは、文章による入力でも、正確に理解されているようです。

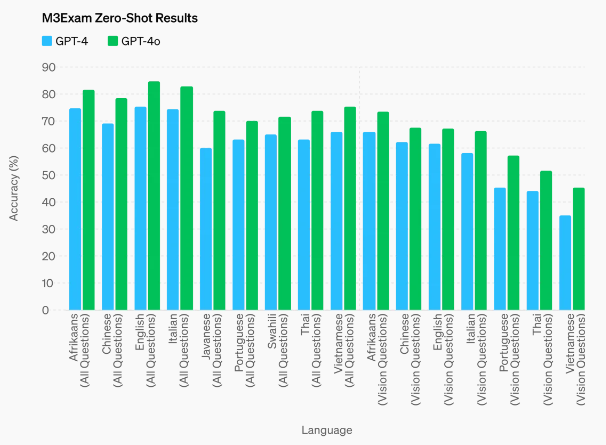

以下は、M3Examのベンチマークです。これは、多言語と視覚の両方の評価であり、他の国の標準化されたテストからの多肢選択問題で構成されており、図や図表が含まれる場合もあります。

他社の画像生成ツールは、主にStable DiffusionやMidjourney、そしてOpenAIのDALL·E 3が主流でした。以下は、それらを基に作成された画像生成のツールです。

- DALL・E2

- Canva AI

- starryai

- shutterstock

- Midjourney

- Microsoft Designer

- Adobe Firefly

- NovelAI Diffusion

- Stable Diffusion

- niji・journey(にじジャーニー)

- Playground AI

- Stable Diffusion Online

- Craiyon

- Photopea

- Nero AI

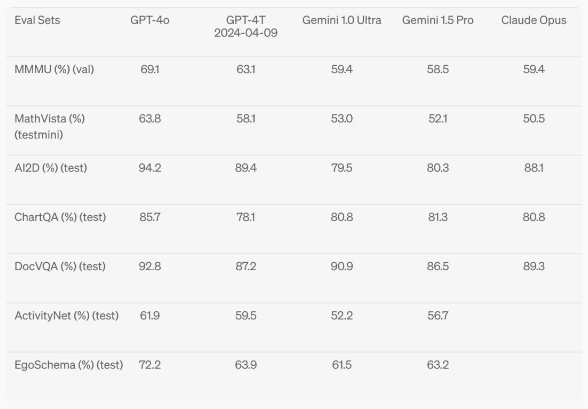

GPT-4oは視覚認識ベンチマークで最先端の性能を達成し、すべての視覚評価は0ショットで、MMMU、MathVista、ChartQAは0ショットCoTです。そのため、GPT-4Turbo、Gemini、Claudeに対するいくつかの視覚理解ベンチマークにおいて、最先端の視覚理解能力を達成しています。

GPT-4oに関するよくある質問

GPT-4oに関するよくある質問をまとめています。今回は、下記をご紹介します。

- GPT-4oの月額料金はいくらですか?

- GPT-4oのAPI料金設定はいくらですか?

- GPT-4oは無料で使えますか?

- GPT-4oはいつリリースされましたか?

- GPT-4oとGPT-4の違いは何ですか?

- GPT-4oができることは何ですか?

GPT-4oの月額料金はいくらですか?

GPT-4oを個人利用する場合には、月額20ドルがかかります。ただし、チームで利用する場合には、月額30ドルがかかります。

GPT-4oを利用するには、ChatGPT Plusを契約する必要があり、個人利用とチーム利用で料金が異なります。また、チーム利用の場合は、年間契約になると月額料金は25ドルとなります。安全な拡張を目指す革新的な企業向けの料金プランも用意されているので、その場合には、営業担当に問い合わせましょう。

ChatGPT Plusの料金については、公式サイトのChatGPTに関する価格設定が参考になります。

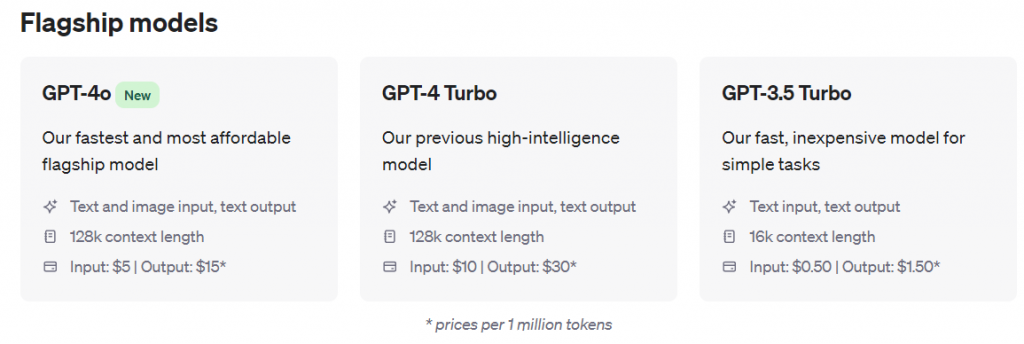

GPT-4oのAPI料金設定はいくらですか?

GPT-4oをAPIで利用する場合の料金は、100万トークンの入力ごとに5ドルがかかり、100万トークンの出力ごとに15ドルがかかります。この料金は、GPT-4 Turboと比較した場合の半額の料金です。

GPT-4oのAPI価格については、公式サイトのAPIに関する価格設定が参考になります。

GPT-4oは無料で使えますか?

GPT-4oは無料では利用できません。一般的に利用されるChatGPTでの個人利用では、月額20ドルがかかります。GPT-4oのAPI料金は、利用した分だけかかります。

GPT-4oはいつリリースされましたか?

GPT-4oは、OpenAIによって、2024年5月13日にリリースされました。過去、リリースされたモデルであるGPT-4 Turboは、2024年11月にリリースされ、GPT-4は、2023年3月14日にリリースされました。

GPT-4oとGPT-4の違いは何ですか?

GPT-4とGPT-4oの違いは、下記の比較表をご確認下さい。

| 機能/モデル | GPT-4o | GPT-4 Turbo | GPT-4 |

|---|---|---|---|

| リリース日 | 2024年5月13日 | 2023年11月 | 2023年3月14日 |

| コンテキストウィンドウ | 128,000トークン | 128,000トークン | 8,192トークン |

| 知識のカットオフ | 2023年10月 | 2023年4月 | 2021年9月 |

| 入力モダリティ | テキスト、画像、オーディオ(完全マルチモーダル対応) | テキスト、画像(強化) | テキスト、限定的な画像処理 |

| ビジョン機能 | 高度なビジョンとオーディオ機能 | 強化、DALL-E 3を使用した画像生成を含む | 基本 |

| マルチモーダル機能 | テキスト、画像、オーディオの完全統合 | 強化された画像とテキスト処理 | 限定的 |

| コスト | GPT-4 Turboより50%安い | GPT-4に比べて入力トークンが3倍安い | 標準 |

参考文献

Reddit|Direct speed comparison between gpt-4 and gpt-4o. Side by side started with same image prompt .

OpenAI Developer Forum|GPT-4 vs GPT-4o? Which is the better? – API

GPT-4oができることは何ですか?

GPT-4oができることは、次のとおりです。

- GPT-4oは128,000トークンまでの大規模なコンテキストウィンドウをサポートしており、長い会話や文書の一貫性を維持できるため、詳細な分析に適しています。

- GPT-4oは、テキスト、音声、画像を統合した単一のモデルであり、異なるデータタイプの組み合わせを処理して応答することができます。モデルは音声、画像、テキストを同じ速度で理解でき、音声、画像、テキストを介して応答を生成することもできます。

- GPT-4oはリアルタイムで言語間の翻訳をサポートしており、マルチモーダル機能により実現しています。

- GPT-4oは音声に関する高度な処理能力を持ち、50以上の異なる言語を扱うことができます。

- データ分析機能により、GPT-4oはデータチャートに含まれるデータを分析することができ、分析やプロンプトに基づいてデータチャートを作成することもできます。

- GPT-4oは、ファイルアップロードをサポートしており、特定のデータの分析を行うことができます。

- GPT-4oは、過去のやりとりを記憶し、より長い会話の文脈を維持することができます。

- GPT-4oは、感情のニュアンスを持つ音声を生成できるため、繊細でニュアンスのあるコミュニケーションを必要とするアプリケーションに効果的です。

- リアルタイムインタラクションが可能で、実際の遅延がほとんどなく言葉のやりとりができます。

- GPT-4oは、誤った情報や誤解を招く情報の生成を最小限に抑えるために設計されており、出力が適切で安全であることを保証するための強化された安全プロトコルが含まれています。

- 以前のGPT-4モデル同様、GPT-4oは知識ベースで訓練されており、質問に対する回答が可能です。

- 以前のGPT-4モデルと同様、GPT-4oは一般的なテキストLLMタスク、つまりテキストの要約と生成を実行することができます。

- GPT-4oは、テキスト、音声、ビデオの異なるモダリティにわたるユーザーの感情を理解することができます。

- モデルは、画像とビデオを分析することができ、ユーザーがアップロードした視覚コンテンツを理解し、説明し、分析を提供することができます。

GPT-4oは機能性と性能の両面で最も高い能力を持つOpenAIのモデルです。

参考文献

OpenAI|ChatGPT can now see, hear, and speak

GPT-4oの使い方は?

ChatGPTにログインして、ChatGPT Plusに契約すると、利用できます。下記の画像は、ChatGPT Plusに課金していないユーザーがChatGPTにログインした場合の画面です。

GPT-4oはiPhoneアプリで使えますか?

GPT-4oは、iPhoneアプリでも利用できます。AppStoreから、ChatGPTをダウンロードして、インストールしてみましょう。

GPT-4oに関するまとめ

GPT-4Turboと比較して、OpenAIは2倍高速で、入力トークン(100万個あたり500ドル)と出力トークン(100万個あたり1,500ドル)の両方で50%安く、レート制限が5倍(1分あたり最大1,000万トークン)であるように設計されています。

GPT-4oは128Kのコンテキスト・ウィンドウを持ち、2023年10月にナレッジ・カットオフされる。新しい能力の一部は現在、ChatGPTを通じてオンラインで、デスクトップとモバイルデバイスのChatGPTアプリを通じて、OpenAI APIを通じて(APIリリースノートを参照)、Microsoft Azureを通じて利用可能です。

GPT-4oは、日本語で「ジーピーティーフォーオー」です。

下記は、OpenAIのXに投稿されたGPT-4oの発表です。

OpenAIのCTOであるミラ・ムラティ(Mira Murati)は「GPT-4o は GPT-4 Turbo の 2 倍の速度であり、コストは半分である」と述べています。

そして、OpenAIのCEOであるサム・アルトマン(Sam Altman)は、GPT-4oの発表後に、自身のブログ投稿にて、「新しい音声 (およびビデオ) モードは、私がこれまで使用した中で最高のコンピューター インターフェイスです。」と綴っています。

下記は、GPT-4o同士が歌っている様子です。

信じられないAIの進歩を感じますね。

では、ChatGPTにGPT-4oが搭載されたので、テキスト部分の速度はどのように変わったのでしょうか。まずは、画面左上からモデルを「GPT-4o」に変更します。

GPT-4oは、音声の応答速度がとても速いとOpenAIの発表でありましたが、入力スピードも速くなったとのことで、実際に確認してみました!

めちゃくちゃ早い!

GPT-3.5のような出力スピード!

英語以外の言語テキストのパフォーマンスは、大幅に改善されました。APIは、より高速化され、API料金は半額です。 GPT-4oのAPIは、GPT-4 TurboのAPIと比較した際に、入力価格と出力価格がそれぞれ半額になっています。

マーケティングに役立つ!ChatGPT活用のプロフェッショナルガイド

- Webサイト担当者に役立つ!ChatGPTプロンプト7選

- ChatGPTとは?SEO的使い方・出来ること・注意点を解説!

ChatGPTを利用することで、企業の経営・マーケティング戦略をより綿密なものにすることができます。ここでは、ChatGPTを利用したマーケター向け資料を3つ紹介します。

Webサイト担当者に役立つ!ChatGPTプロンプト7選

本資料では、Webサイト担当者のために、すぐに活用できる7つのプロンプトテンプレートを厳選してご提供しています。

▼こんな方におすすめのノウハウです

・企業でWebサイト運営を担当者

・簡単に業務効率を向上させたい方

資料のダウンロードはこちら

ChatGPTとは?SEO的使い方・出来ること・注意点を解説!

今注目のChatGPTは、対話形式で素早く回答を得られる非常に便利なツールです。しかし、そのままの回答を利用して大量のページを作成する手法には問題が生じることがあります。

では、コンテンツ作成においてChatGPTを効果的に活用するためには、どのような点に注意すべきなのでしょうか?本資料では、ChatGPTの概要や登録方法から、使用時に留意すべきポイントまで、詳細に解説しています。

ChatGPTを使って

・ライターに依頼する手間を省ける

・個人でも簡単に記事を大量作成できる

・記事作成の手間が大幅に軽減される

・メルマガなどの文章作成も効率化できる

と期待している方は、ぜひ本資料をご覧ください。

コンテンツ作成時に注意すべき点や、ChatGPTの効果的な使い方を、ステップごとに詳しく解説します!

資料のダウンロードはこちら

参考文献

OpenAI|Hello GPT-4o

OpenAI|ChatGPT can now see, hear, and speak

OpenAI|Introducing GPT-4o and more tools to ChatGPT free users

OpenAI|Spring Update

CNBC|OpenAI launches new AI model and desktop version of ChatGPT

Business Today|What is OpenAI’s new GPT-4o and why it might be the most interesting update yet

【ChatGPT】無料で使う「GPT-4o」その概要と注意点 – ITmedia

人間に近づいた「GPT-4o」3つの進化のポイント

マーケメディアでは、生成AIに関連する「人工知能(AI)」を活用したマーケティング術まとめ」や、「ChatGPTなど、「対話型AI」に関するマーケター向け資料まとめ」などのマーケティング資料を企業のマーケティング担当者向けに無料で公開しているよ!

コメント