AIガバナンスとは、人工知能(AI)技術やシステムの開発、導入、運用、および監督に関連するルール、原則、規制、プロセス、および枠組みを指します。

AIは急速に進化し、様々な分野で利用されていますが、その進展には潜在的なリスクや課題も存在します。

AIを使用したITシステムやサービスを開発・利用・提供するにあたり、社会規範や制度を遵守し活動を統制するための、管理体制や運用のことです。

NTT Data|AIガバナンスとAIの品質保証

AIガバナンスの目的は、AIシステムの透明性、公平性、倫理的配慮、安全性、および法的遵守を確保し、社会的な利益と個人の権利を守ることです。

本記事で考察している適切なAIガバナンスの実施は、信頼性のあるAI技術の発展と、その恩恵を社会全体にもたらすために非常に重要です。

企業、政府機関、研究機関、個人が協力して、適切なAIガバナンスの実現に努めることが求められています。

企業担当者の方で、生成AIに関するリスク対策に興味がある方は「生成AIのリスクガイドライン|企業に求められるリスク対策と事例」をご確認下さい。

本記事では、次のような内容を解説します。

それでは、AIガバナンスについて詳しく解説します。

AIガバナンスの基礎知識

人工知能(AI)技術の進化は、私たちの社会やビジネスに革命的な変化をもたらしています。しかし、その進展と共に懸念材料も増えており、AIシステムがもたらす潜在的なリスクや課題に対処する必要性が高まっています。

AIガバナンスは、急速なAI技術の進化に対応し、社会的な利益と個人の権利を守るための重要な枠組みです。未来のAI倫理を築くためには、透明性、公正性、安全性、倫理的配慮を追求する取り組みが重要であり、全てのステークホルダーが協力してその実現に向けて努力することが求められます。

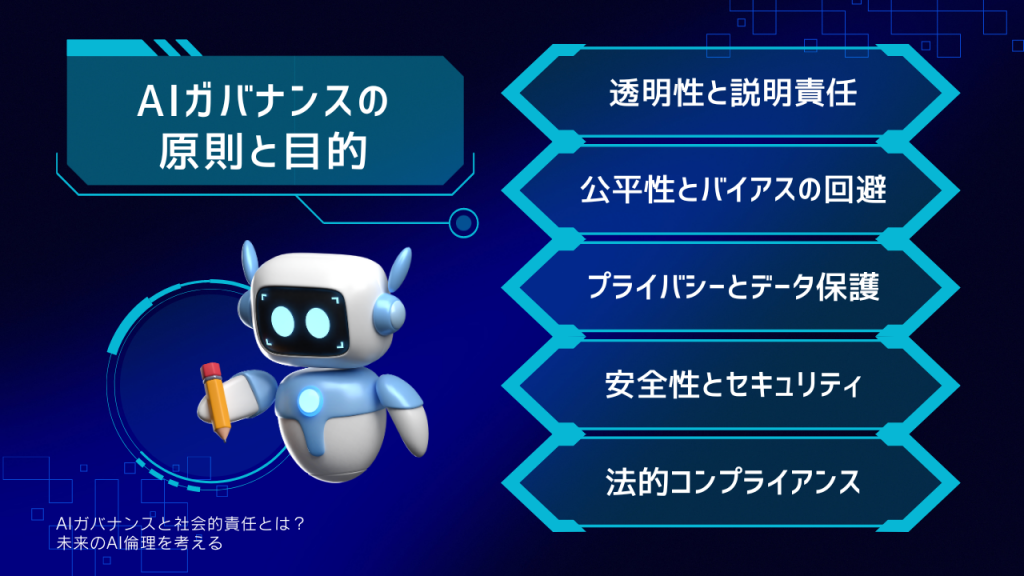

AIガバナンスの原則と目的

AIガバナンスの基本的な原則は、人間中心のアプローチに基づいています。つまり、AI技術の発展は人間の利益に適合し、個人の権利と尊厳を尊重することが求められます。これに加えて、AIガバナンスの目的は以下の通りです。

1.透明性と説明責任

AIシステムの意思決定過程を理解可能にすることで、その結果を説明できるようにします。

2.公平性とバイアスの回避

AIシステムが特定の個人やグループに対して差別的な結果を出さないように、公平性を確保します。

3.プライバシーとデータ保護

個人情報の保護やデータの適切な管理を行い、プライバシーを守ります。

4.安全性とセキュリティ

AIシステムが攻撃や誤動作に対して脆弱でないよう、適切なセキュリティ対策を実施します。

5.法的コンプライアンス

AIの利用は適用される法律や規制に準拠します。

AIガバナンスの実践と課題

AIガバナンスの実践と課題について、透明性、公平性、法的コンプライアンス、データプライバシー保護という三つの側面に焦点を当てて考察していきます。

これらの課題に対する適切な対策を取り入れることで、より持続可能なAI社会の実現に向けて前進できることでしょう。まずそれぞれの課題を知り、具体的な対策を理解していきます。

社会的責任を果たすためのAI技術の透明性

AI(人工知能)技術の進化は驚異的なスピードで進んでいますが、その発展に伴い新たな課題が浮上しています。特に、AIシステムが社会に与える影響とその責任を果たすためには、透明性の重要性が増してきています。

AIシステムが人間に影響を与える場面では、透明性が不可欠です。

透明性とは、AIシステムの内部の仕組みや意思決定のプロセスが明確に理解されることを指します。透明性が高まれば、AIがどのような判断を下し、どのようなデータを利用しているかを理解しやすくなります。これによって、AIの意思決定が誤解されることや、偏った結果が生じるリスクを軽減することができます。

透明性を高めるためには、AIの開発・運用段階での情報公開が必要です。個人情報の保護を確保しつつ、技術的な仕組みやアルゴリズムの公開、透明なデータ収集の方針などが含まれます。また、AIの導入に当たっては、社会的な議論と意思決定のプロセスに広く関与することが重要です。これによって、倫理的な観点からもAIシステムがより信頼性のあるものとなります。

公平性と倫理を保つためのAIシステムの課題と解決策

AI技術が導入される際のもう一つの重要な課題が公平性です。

AIシステムは、その学習に使用されるデータやアルゴリズムの設計によって、個々の意見や人種、性別、民族などに基づくバイアスを持ち込む可能性があります。

このようなバイアスは、特定のグループに不公平な結果をもたらす可能性があり、社会的な問題を引き起こす恐れがあります。

公平性を確保するためには、AIシステムのトレーニングデータが多様な集団を代表するものであることが重要です。バイアスを検出し、それを排除するための適切な手法を採用することで、より公平なAIシステムを実現できます。また、開発段階から倫理的な検討を行い、その技術の利用に関するガイドラインを策定することも重要です。

法的コンプライアンスとデータプライバシーの重要性

AI技術の普及に伴い、法的なコンプライアンスとデータプライバシーの保護がますます重要となっています。特に、個人情報や機密情報を扱うAIシステムは、その取り扱いに厳格な規制と監督が求められます。

個人情報保護法やデータ保護規制に対する遵守が不可欠であり、ユーザーのデータが適切に保護されることが求められます。加えて、AIシステムの利用に関しては、倫理的な観点からも適切なガイドラインを策定することが必要です。

法的コンプライアンスとデータプライバシーの重要性を理解し、それに対応する適切な対策を講じることで、AI技術の信頼性を高め、社会的な信頼を築くことが可能です。

AIガバナンスをそれぞれの立場から考える

AIガバナンスにおいて個人、企業、政府の役割と取り組み方を理解し、協力することで、より信頼性のある、社会的に有益なAI技術の発展が可能となります。

個人が意識的な利用をし、企業が社会的責任を果たし、政府が適切な枠組みを整備することで、AIは人々の生活や産業の向上に寄与するとともに、社会的な課題への解決策としても活用されることが期待されます。

さらに、異なる立場の関係者が協力することで、AI技術の偏りやバイアスを排除し、多様な価値観を尊重する包括的な社会の実現に寄与することが可能です。個人、企業、政府が互いに学び合い、対話を重ねることで、より成熟したAIガバナンスの枠組みを構築し、社会全体の利益に資するAIの未来を築き上げていくでしょう。

個人の役割

AI技術の進化により、個人の日常生活や仕事においてもAIの利用が増えてきました。個人がAIを利用する際には、倫理的な意思決定が重要な要素となります。

まず第一に、個人はAIの利用目的に対して注意深く検討する必要があります。AIを導入することで得られる利益や便益を評価し、それが他者に与える影響も考慮することが重要です。例えば、AIによって自動化された仕組みが一部の人々の雇用を脅かす可能性がある場合、倫理的な側面を考慮した意思決定が求められるでしょう。

また、個人がAIシステムの開発や運用に参加する場合にも倫理的な意識が重要です。

データ収集やアルゴリズムの設計において、個人のバイアスを排除し、公正で公平なAIシステムを実現するために努力することが必要です。

企業のリーダーシップ

企業はAI技術の発展に大きな影響力を持ち、リーダーシップを発揮することが求められます。AIガバナンス戦略においては、単なる利益追求だけでなく、社会的な利益を考慮した取り組みが重要です。

例えば、企業はAIシステムの開発・運用において透明性を重視し、利害関係者に対して適切な情報開示を行うことが重要です。社会的な影響を持つAIについては、外部の専門家や利害関係者からのフィードバックを取り入れることで、より公正な判断が可能となります。

また、企業はAIシステムの公平性にも配慮するべきです。多様な人々に対して公正なサービスを提供するため、バイアスの排除やデータの偏りに対処する取り組みが必要です。

政策立案と法規制

政府や規制機関の役割は、AI技術の促進と同時にリスクを抑制する枠組みを整備することです。AIガバナンスのためには適切な政策立案と法規制が欠かせません。

政府はAI技術の研究開発を支援し、イノベーションを促進すると同時に、個人情報保護やデータセキュリティなどの重要な観点から適切な法律を整備する必要があります。特に、AI技術が医療や金融などの重要な領域で使用される場合は、より厳格な規制が求められるでしょう。

さらに、国際的な連携も重要です。AI技術は国境を越えて影響を及ぼすため、国際的な標準やルールの策定が必要となります。国際的な協力によって、AI技術の進化と利用を持続可能なものとすることが可能です。

AIに向けた国際協力とグローバルスタンダードの必要性

現代社会において、AI技術は経済、医療、交通、エネルギー、教育などの様々な分野で急速に普及しています。

AIの進化は人々の生活を豊かにし、社会に革新をもたらす一方で、倫理的な課題や社会的なリスクをもたらす可能性もあります。

AIガバナンスに向けた国際協力とグローバルスタンダードの確立は、倫理的な課題への対処と持続可能なAI社会の実現に不可欠です。異なる国や地域が協力し、技術の進化と社会的な責任を両立させるための共通の基盤を築くことで、AI技術がより信頼性のある、社会的に有益なものとなるでしょう。

倫理的な課題と国際協力の必要性

AI技術の進展に伴い、個人情報の保護、プライバシーの尊重、バイアスや偏見の排除、自動運転車の安全性、AI兵器の利用など、様々な倫理的な課題が浮上しています。これらの問題は単一の国や地域だけでは解決が難しいものがあります。個々の国や地域が異なるルールや基準を採用すると、国境を越えるAIの利用において混乱やトラブルが生じる可能性があります。

こうした課題に対処するためには、国際協力が不可欠です。国際組織や専門家の会議、国際会議などを通じて、異なる国や地域のステークホルダーが協力し、共通の倫理的な基準や指針を策定することが重要です。国際協力によって、AI技術の利用における最善の実践を共有し合い、グローバルな課題に対しても共通のアプローチを取ることが可能となります。

グローバルスタンダードの重要性

AI技術は国境を越えて利用されることが多いため、グローバルスタンダードの確立が重要です。技術的な標準だけでなく、倫理的な側面に関する共通の基準が必要です。

例えば、AIシステムの透明性を高めるためのガイドライン、公平性の確保、個人情報保護の枠組みなどが含まれます。

グローバルスタンダードが確立されれば、異なる国や地域のAI技術がより効果的に連携し、信頼性の高いサービスを提供できるようになります。また、グローバルスタンダードに従うことで、国際的な利用において適切なリスク管理が行われ、技術の利用に対する信頼性が高まるでしょう。

協力体制の構築とステークホルダーの参加

AIガバナンスに向けた国際協力を実現するためには、政府、産業界、研究機関、市民社会などの多様なステークホルダーが参加する協力体制の構築が重要です。

異なる国や地域のステークホルダーが協力して、異なる文化や価値観を尊重しつつ、共通の目標に向けて取り組むことが必要です。

国際的な協力により、技術の進化と社会の利益を両立させるための枠組みを共有し、より持続可能なAI社会を築くことが可能です。異なる国や地域が協力して共通の問題に取り組むことで、グローバルな課題への解決策を見出すことができ、AIの発展が人類全体の利益に資することが期待されます。

未来を見据えたAIガバナンスの構築へ向けての取り組み

AIの利用拡大に伴い、倫理的な課題や社会的リスクへの対処が急務となっています。未来を見据えた持続可能なAI社会を築くために、AIガバナンスの構築に向けて以下の取り組みが重要となります。

未来を見据えたAIガバナンスの構築には、透明性と公平性の確保、倫理委員会の設立と利害関係者の参画、AI倫理教育の推進が不可欠です。これらの取り組みを通じて、信頼性のある、社会的に有益なAI技術の発展を促進し、持続可能なAI社会を築くことが可能となるでしょう。

透明性と公平性の確保

AIの意思決定は複雑であるため、その透明性を高めることが重要です。利用者や関係者がAIの意思決定プロセスを理解できるような仕組みを導入し、AIシステムの説明可能性を確保することが必要です。また、バイアスの排除や公平性の確保にも努めることで、多様な人々に対して公正なサービスを提供できるようになります。

倫理委員会の設立と利害関係者の参画

AIの倫理的な問題に対処するためには、倫理委員会の設立が重要です。政府、企業、学術機関、市民社会など様々な利害関係者を含む倫理委員会がAIの利用に関するガイドラインや倫理的な指針を策定し、意思決定プロセスにおける倫理的な側面を監視することで、AIの利用に対する信頼性が高まるでしょう。利害関係者の意見を積極的に取り入れることで、より包括的で公正なガバナンスが実現します。

AI倫理教育の推進

AIの利用者や開発者、運用者に対してAI倫理教育を推進することが重要です。倫理的な意識を高めることで、個人がAIを適切に利用し、社会的な影響を理解することができるようになります。また、AI技術を教育や研究に活用する際にも、倫理的な側面を重視したカリキュラムや指導が必要です。

まとめ 未来のAI倫理を築くためのAIガバナンス

AI技術の急速な進展とAIの利用拡大に伴い、倫理的な課題や社会的リスクへの対処が喫緊の課題となっており、未来のAI倫理に対してAIガバナンスの向上に取り組むことが求められています。

未来のAI倫理を考える上で、技術の進化と社会の利益を両立させることが鍵となります。

国際的な協力と利害関係者の参画を通じて、信頼性のある、社会的に有益なAI技術の発展を促進し、持続可能なAI社会を築くことが目指されるでしょう。これらの取り組みによって、未来のAI倫理がより包括的かつ進化することで、AIの可能性を最大限に引き出し、人類全体の福祉に貢献することが期待されます。

参考:一般社団法人 日本ディープラーニング協会|AIガバナンス・エコシステム

本記事では、AIガバナンスについて詳しく解説を行いました。弊社が運営しているマーケMEMOでは、マーケティングに関する最新情報を発信しており、AI系のジャンルでは、ChatGPTの「Code interpreter」や「Custom instructions」について情報発信しています。

マーケメディアでは、マーケティングに関するお役立ち資料として、ホワイトペーパーを無料でダウンロードできるので、まずは下記からビジネス用のメールアドレスを入力し、おすすめ資料を受け取りましょう。

コメント